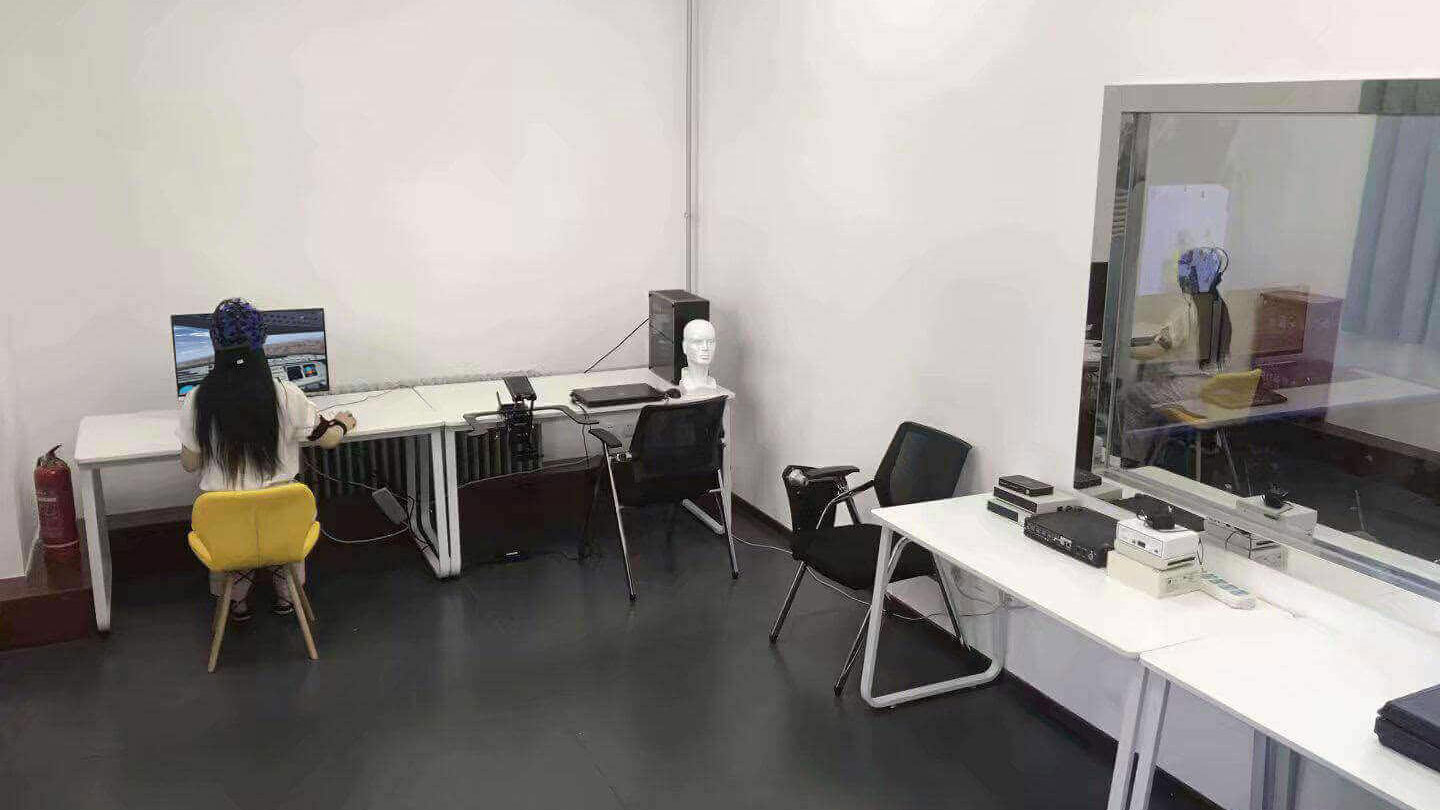

ErgoLAB Behavior行為觀察分析模塊,采用標準攝像頭錄制行為視頻,實時獲取被研究對象的動作,姿勢,運動,位置,表情,情緒,社會交往,人機交互等各種活動,記錄并分析其狀態與表現形式,形成行為-時間-頻次數據庫,記錄與編碼分析個體在活動中的行為頻次或習慣性動作的特點等。通過交互行為觀察,探索心理、生理的外在表現,進一步了解人們行為與心理反應的相互關系。

可同步記錄多路行為視頻,記錄操作者的交互行為及實驗環境信息支持基于移動終端的實時API編碼與事后行為半自動編碼可以按照研究目的進行自由編碼,記錄各種行為,提高分析結果的精準性行為記錄與多類型編碼

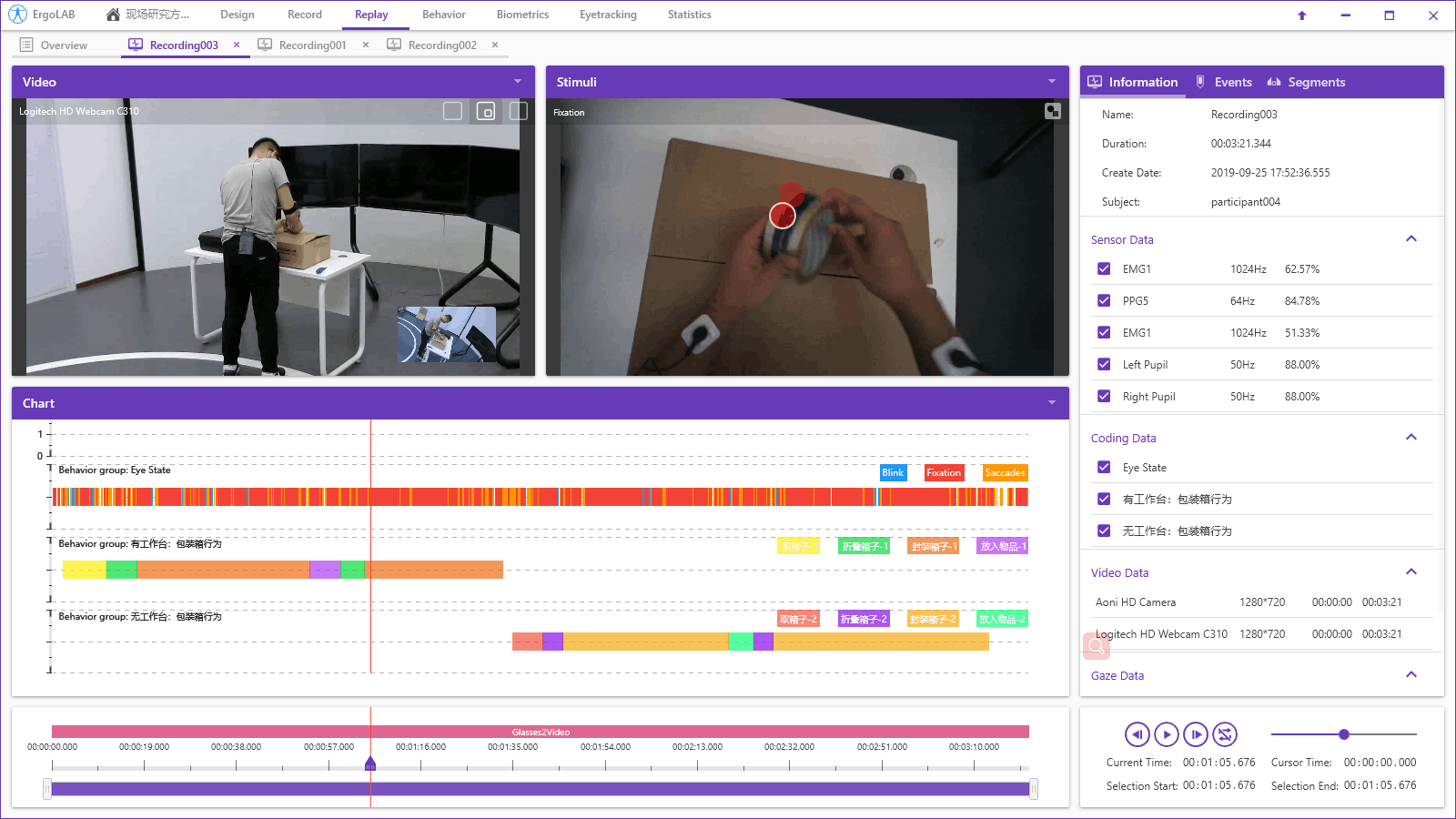

記錄模塊:主要用于記錄實驗參與者的各種行為,支持外部設備以及多路視頻的同步采集與數據傳輸。支持在移動設備中進行使用和數據采集。支持記錄點狀行為以及持續行為。視頻模塊:系統支持實時觀察和離線觀察方式,外部視頻源采集的多路視頻可以被兼容導入到觀察和分析系統中進行數據編碼與統計。系統支持任意格式的視頻導入與播放管理。編碼模塊:系統包含多終端API/TTL實時行為編碼與事件標記應用程序,進行實時行為編碼;支持通過鼠標/快捷鍵等多種方式的離線半自動行為編碼。行為統計分析模塊

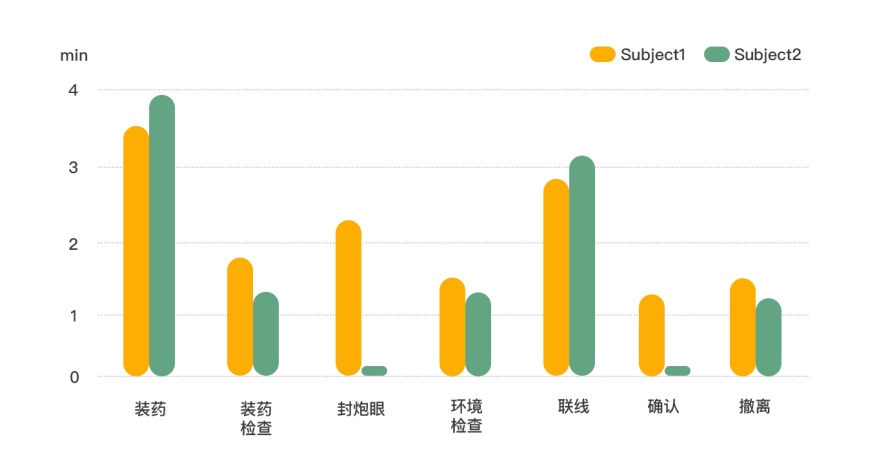

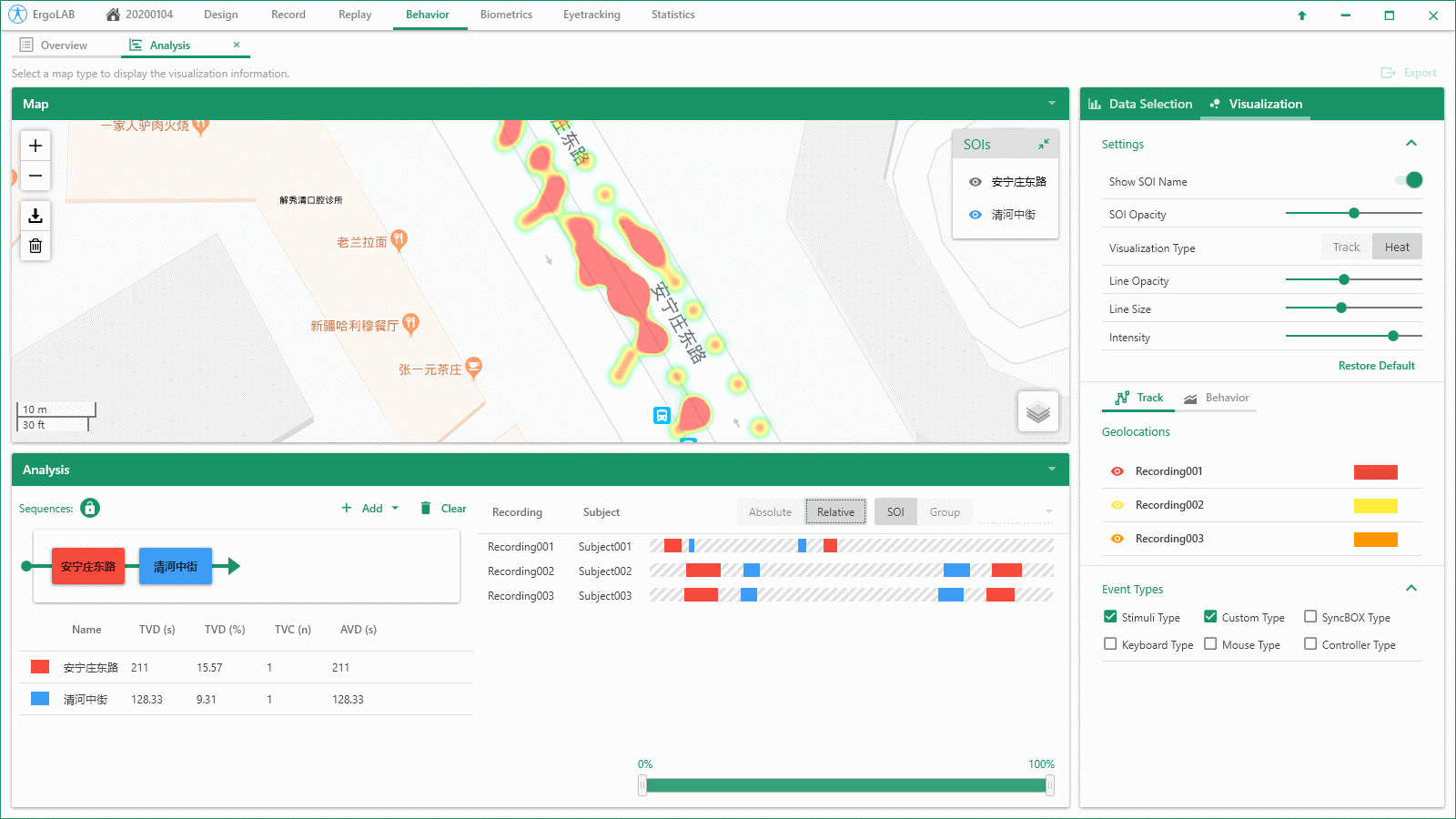

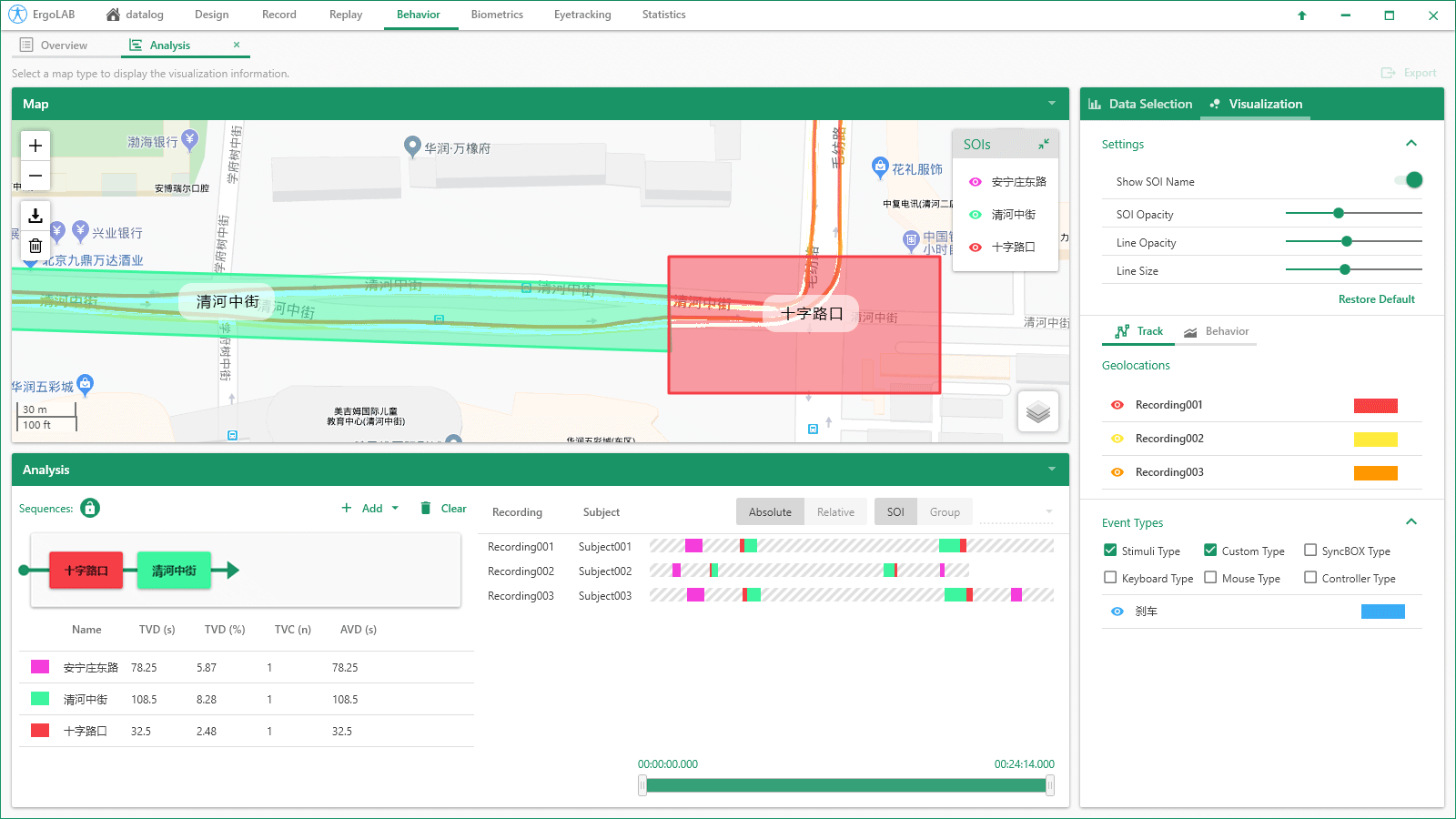

基礎行為統計:系統對所有編碼行為數據進行統計分析,包括每種行為的第一次發生的時間、發生次數、頻率、每次發生的時間、總的持續時間、總的持續時間在全部觀察時間中所占的百分比、最短的持續時間、最長的持續時間、平均持續時間、持續時間的標準差、持續時間間隔下一區間等數據。交互行為數據分析:自動識別多種行為發生的交互關系,針對兩種或多種行為同時發生的時間、次數、概率等數據指標進行統計。支持同一時間點或同一時間段內多模態數據與行為數據的交叉分析。行為順序效應分析:支持一種行為發生在另一種行為之后/之前的多層次數據統計,包括行為之間的延遲效應、順序效應分析,并一鍵導出行為發生的可視化序列性分析報告。編碼行為可視化時空分析

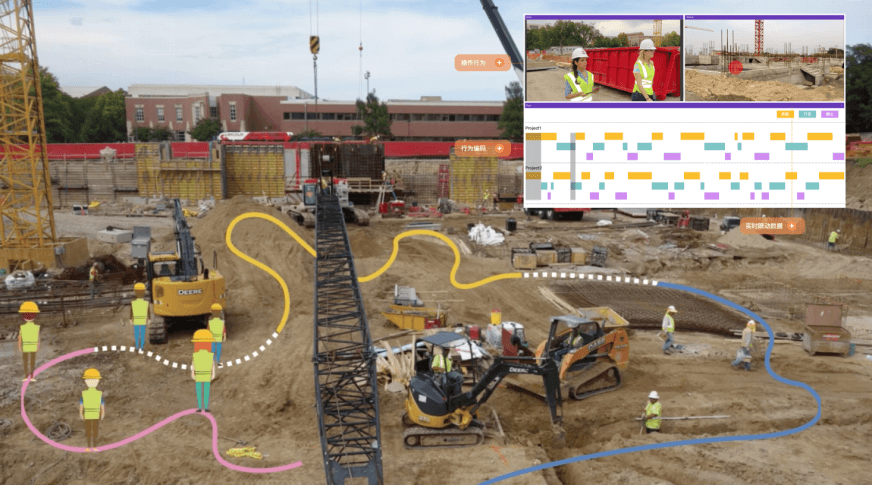

編碼行為可視化時空分析:支持所有行為編碼的數據進入時空分析,系統提供不同類型的熱圖及可視化不同行為發生的時空位置關系。支持多被試的行為數據與動態時空位置的疊加分析。編碼行為時空SOI統計:支持自動統計SOI興趣區域內的行為編碼數據,統計指標包括:SOI內行為發生的次數、每分鐘發生的次數、總持續時間、最小持續時間、最大持續時間、平均持續時間等。多維度數據的交叉分析:基于多維度人機環境時空數據同步技術,行為數據可以與項目中采集的任意數據源進行交叉統計分析。如基于時間同步的眼動數據、生理數據等。實現時間軸數據的交集可視化以及多維度數據的綜合統計。ErgoLAB人機環境同步云平臺可人-機-環境多維度數據的同步采集與綜合分析,包括眼動追蹤、生理測量、生物力學、腦電、腦成像、行為、人機交互、動作姿態、面部表情、主觀評 價、時空行為、模擬器、物理環境等,為科學研究及應用提供完整的數據指標。平臺可完成完整的實驗和測評流程,包括項目管理-試驗設計-同步采集-信號處理-數據分析-人工智能應用-可視化報告,支持基于云架構技術的團體測試和大數據云管理。

北京市海淀區安寧莊后街12號院1號樓一層、三層

北京市海淀區安寧莊后街12號院1號樓一層、三層 sales@kingfar.cn

sales@kingfar.cn

在線客服

在線客服